Ежедневно в интернете появляется огромное количество новых

материалов: создаются сайты, обновляются старые веб-страницы,

загружаются фотографии и видеофайлы. Без невидимых поисковых роботов

невозможно было бы найти во всемирной паутине ни один из этих

документов. Альтернативы подобным роботизированным программам на данный

момент времени не существует. Что такое поисковый робот, зачем он нужен и

как функционируют?

Кстати сделать robots txt для сайта wordpress можно на сайте itshnick.ru .

Что такое поисковый робот

Поисковый

робот сайтов (поисковых систем) – это автоматическая программа, которая

способна посещать миллионы веб-страниц, быстро перемещаясь по интернету

без вмешательства оператора. Боты постоянно сканируют пространство Всемирной паутины,

находят новые интернет-страницы и регулярно посещают уже

проиндексированные. Другие названия поисковых роботов: пауки, краулеры,

боты.

Зачем нужны поисковые роботы

Основная

функция, которую выполняют поисковые роботы, – индексация веб-страниц, а

также текстов, изображений, аудио- и видеофайлов, находящихся на них.

Боты проверяют ссылки, зеркала сайтов (копии) и обновления. Роботы также

осуществляют контроль HTML-кода на предмет соотвествия нормам Всемирной

организации, которая разрабатывает и внедряет технологические стандарты

для Всемирной паутины.

Что такое индексация и зачем она нужна

Индексация

– это, собственно, и есть процесс посещения определенной веб-страницы

поисковыми роботами. Программа сканирует тексты, размещенные на сайте,

изображения, видео, исходящие ссылки, после чего страница появляется в

результатах поиска. В некоторых случаях сайт не может быть просканирован

автоматически, тогда он может быть добавлен в поисковую систему вручную

веб-мастером. Как правило, это происходит при отсутствии внешних ссылок на определенную (часто только недавно созданную) страницу.

Как работают поисковые роботы

Каждая

поисковая система имеет собственного бота, при этом поисковый робот

Google может значительно отличаться по механизму работы от аналогичной

программы "Яндекса" или других систем.

В

общих чертах принцип работы робота заключается в следующем: программа

«приходит» на сайт по внешним ссылкам и, начиная с главной страницы,

«читает» веб-ресурс (в том числе просматривая те служебные данные,

которые не видит пользователь). Бот может как перемещаться между

страницами одного сайта, так и переходить на другие.

Как программа

выбирает, какой сайт индексировать? Чаще всего «путешествие» паука

начинается с новостных сайтов или крупных ресурсов, каталогов и

агрегаторов с большой ссылочной массой. Поисковый робот непрерывно

сканирует страницы одну за другой, на скорость и последовательность

индексации влияют следующие факторы:

- внутренние:

перелиновка (внутренние ссылки между страницами одного и того же

ресурса), размер сайта, правильность кода, удобство для пользователей и

так далее;

- внешние: общий объем ссылочной массы, которая ведет на сайт.

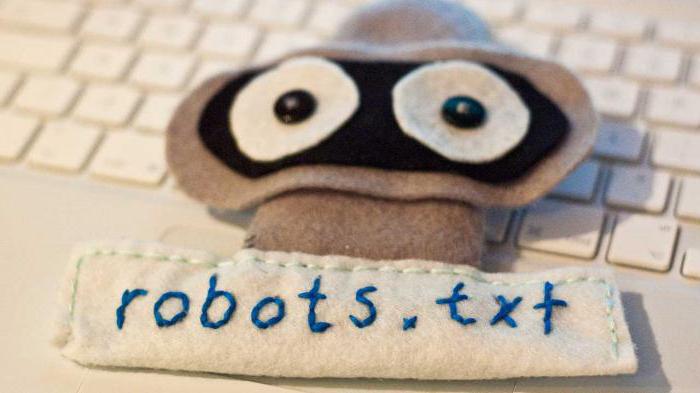

Первым

делом поисковый робот ищет на любом сайте файл robots.txt. Дальнейшая

индексация ресурса проводится, основываясь на информации, полученной

именно от этого документа. Файл содержит точные инструкции для "пауков",

что позволяет повысить шансы посещения страницы поисковыми роботами, а

следовательно, и добиться скорейшего попадания сайта в выдачу "Яндекса"

или Google.

Программы-аналоги поисковых роботов

Часто

понятие «поисковый робот» путают с интеллектуальными, пользовательскими

или автономными агентами, "муравьями" или "червями". Значительные

отличия имееются только по сравнению с агентами, другие определения

обозначают схожие виды роботов.

Так, агенты могут быть:

- интеллектуальными:

программы, которые перемещаются от сайта к сайту, самостоятельно решая,

как поступать дальше; они мало распространены в интернете;

- автономными:

такие агенты помогают пользователю в выборе продукта, поиске или

заполнении форм, это так называемые фильтры, которые мало относятся к

сетевым программам.;

- пользовательскими: программы

способствуют взаимодействию пользователя со Всемирной паутиной, это

браузеры (например, Opera, IE, Google Chrome, Firefox), мессенджеры

(Viber, Telegram) или почтовые программы (MS Outlook или Qualcomm).

"Муравьи"

и "черви" больше схожи с поисковыми "пауками". Первые образуют между

собой сеть и слаженно взаимодействуют подобно настоящей муравьиной

колонии, "черви" же способны самовоспроизводиться, в остальном действуют

так же, как и стандартный поисковый робот.

Разновидности поисковых роботов

Различают множество разновидностей поисковых роботов. В зависимости от назначения программы они бывают:

- «Зеркальными» - просматривают дубликаты сайтов.

- Мобильными – нацелены на мобильные версии интернет-страниц.

- Быстродействующими – фиксируют новую информацию оперативно, просматривая последние обновления.

- Ссылочными – индексируют ссылки, подсчитывают их количество.

- Индексаторами различных типов контента – отдельных программ для текста, аудио- и видеозаписей, изображений.

- «Шпионскими» - ищут страницы, которые еще не отображаются в поисковой системе.

- «Дятлами» - периодически посещают сайты, чтобы проверить их актуальность и работоспособность.

- Национальными – просматривают веб-ресурсы, расположенные на доменах одной страны (например, .ru, .kz или .ua).

- Глобальными – индексируют все национальные сайты.

Роботы основных поисковых систем

Существуют

также отдельные роботы поисковых систем. В теории их функциональность

может значительно различаться, но на практике программы практически

идентичны. Основные отличия индексации интернет-страниц роботами двух

основных поисковых систем состоят в следующем:

- Строгость проверки. Считается, что механизм поискового робота "Яндекса" несколько строже

оценивает сайт на соответствие стандартам Всемирной паутины.

- Сохранение целостности сайта. Поисковый робот Google индексирует сайт целиком (в том числе медиаконтент), "Яндекс" же может просматривать страницы выборочно.

- Скорость проверки новых страниц. Google добавляет новый ресурс в поисковую выдачу в течение нескольких

дней, в случае с "Яндексом" процесс может растянуться на две недели и

более.

- Частота переиндексации. Поисковый робот "Яндекса" проверяет наличие обновлений пару раз в неделю, а Google – один раз в 14 дней.

Интернет,

конечно же, не ограничивается двумя поисковыми системами. Другие

поисковики имеют своих роботов, которые следуют собственным параметрам

индексации. Кроме того, существует несколько "пауков", которые

разработаны не крупными поисковыми ресурсами, а отдельными командами или

веб-мастерами.

Распространенные заблуждения

Вопреки

распространенному мнению, "пауки" не обрабатывают полученную информацию.

Программа только сканирует и сохраняет веб-страницы, а дальнейшей

обработкой занимаются совершенно другие роботы.

Также многие

пользователи считают, что поисковые роботы оказывают негативное

воздействие и «вредны» интернету. Действительно, отдельные версии

"пауков" могут значительно перегружать сервера. Имеет место и

человеческий фактор – веб-мастер, который создавал программу, может

допускать ошибки в настройках робота. Все же большинство действующих

программ хорошо спроектированы и профессионально управляются, а любые

возникающие неполадки оперативно устраняются.

Как управлять индексацией

Поисковые

роботы являются автоматическими программами, но процесс индексации

может частично контролироваться веб-мастером. В этом значительно

помогает внешняя и внутренняя оптимизация ресурса. Кроме того, можно

вручную добавить новый сайт в поисковую систему: крупные ресурсы имеют

специальные формы регистрации веб-страниц.

Вас заинтересует

Топ "Яндекса". Продвижение сайта в топ "Яндекса" itht.ru

Что такое seo-оптимизация сайтов и для чего она нужна seo-profisseonal.ru

Что такое ссылка? Виды ссылок, раскрутка сайта от vtop.kz

Что такое SEO? Продвижение и заработок на сайте. Лучшее продвижение от otclick.pro

Каре Халворсен представил нового робота MorpHex MKII